搜索

智东西 作家 | 程茜 裁剪 | 心缘 智东西9月12日报说念,今天凌晨,阿里通义实际室进展发布下一代基础模子架构Qwen3-Next,并考试了基于该架构的Qwen3-Next-80B-A3B-Base模子,该模子领有800亿个参数仅激活30亿个参数。 Base模子在Qwen3预考试数据的子集15T tokens上进行,仅需Qwen3-32B 9.3%的GPU计议资源,针对越过32k的荆棘文,推理费解量可达到Qwen3-32B的10倍以上。 同期,基于Base模子,阿里开源了Qwen3-Nex

智东西

智东西

智东西9月12日报说念,今天凌晨,阿里通义实际室进展发布下一代基础模子架构Qwen3-Next,并考试了基于该架构的Qwen3-Next-80B-A3B-Base模子,该模子领有800亿个参数仅激活30亿个参数。

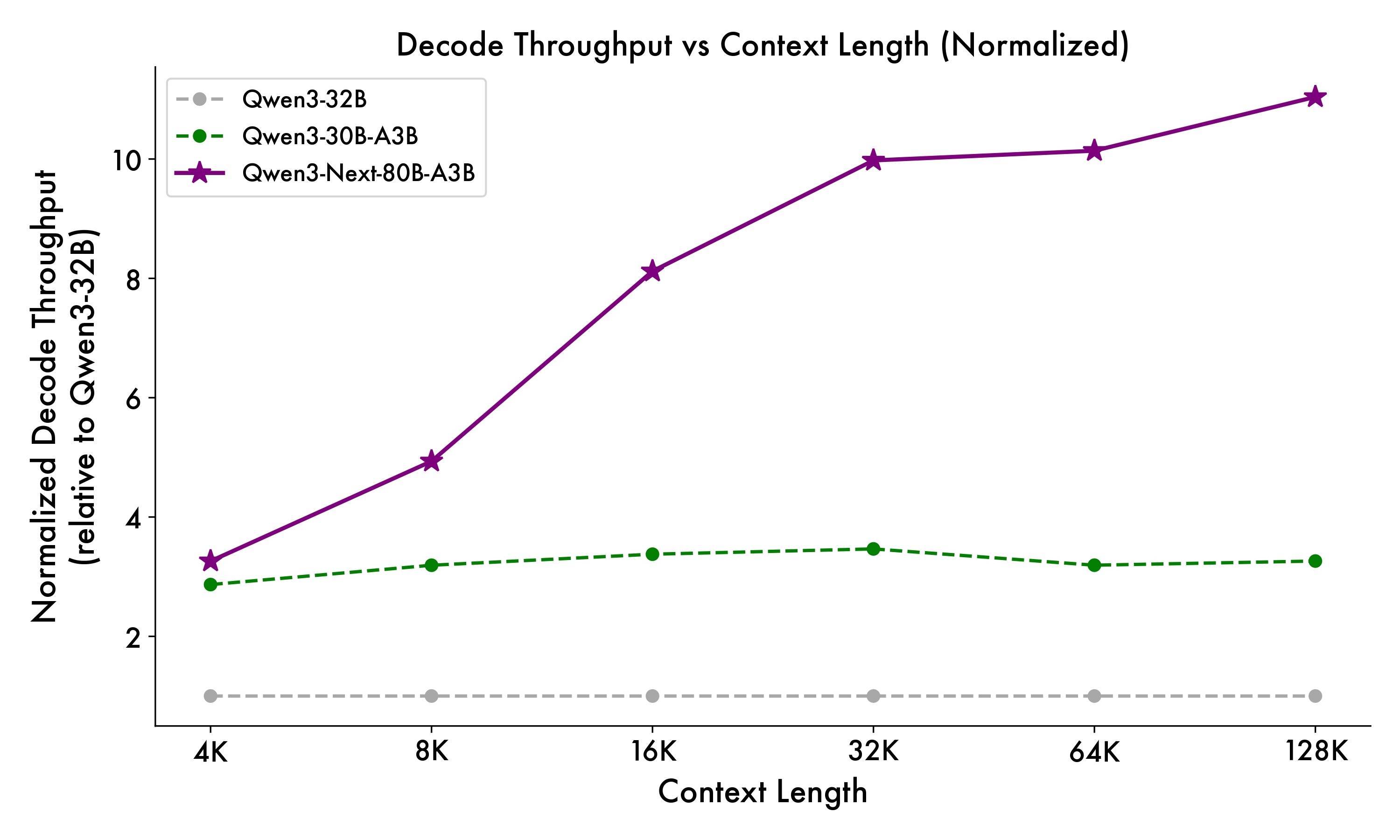

Base模子在Qwen3预考试数据的子集15T tokens上进行,仅需Qwen3-32B 9.3%的GPU计议资源,针对越过32k的荆棘文,推理费解量可达到Qwen3-32B的10倍以上。

同期,基于Base模子,阿里开源了Qwen3-Next-80B-A3B的提示模子(Instruct)和念念维模子(Thinking),模子维持原生262144个token荆棘文长度,可扩张至1010000个token。

其中,Qwen3-Next-80B-A3B-Instruct仅维持提示(非念念考)模式,其输出中不生成<think></think>块;Qwen3-Next-80B-A3B-Thinking仅维持念念考模式,为了强制模子进行念念考,默许聊天模板自动包含<think>。

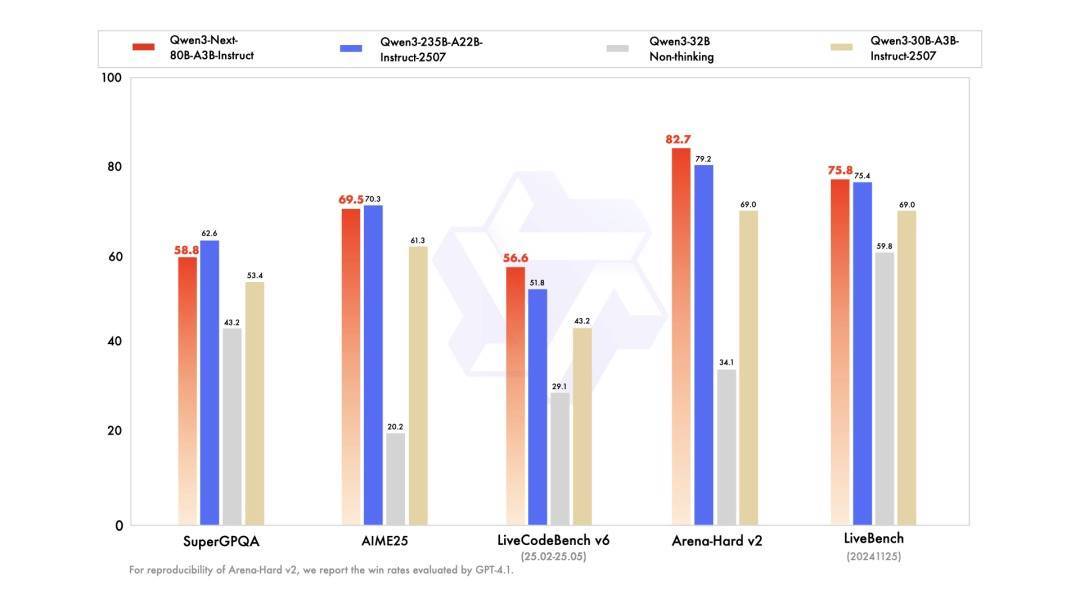

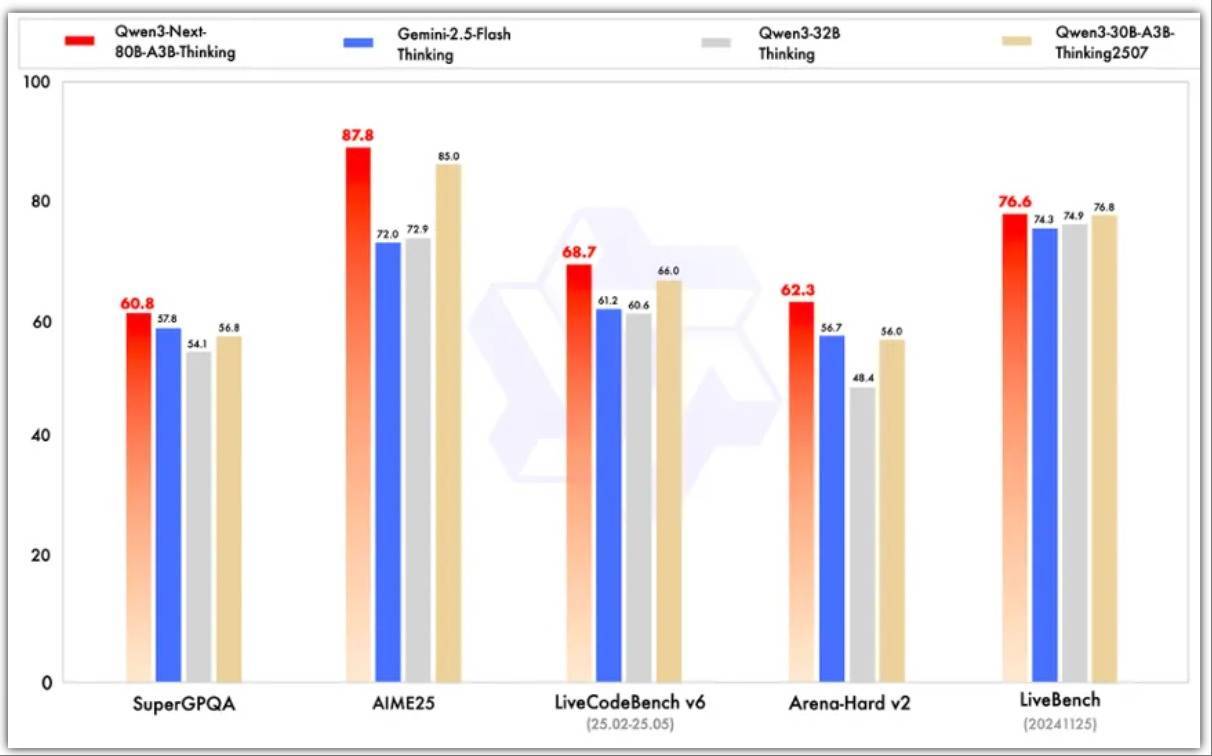

提示模子的性能证据与参数范围更大的Qwen3-235B-A22B-Instruct-2507相配,念念维模子优于谷歌闭源模子Gemini-2.5-Flash-Thinking。

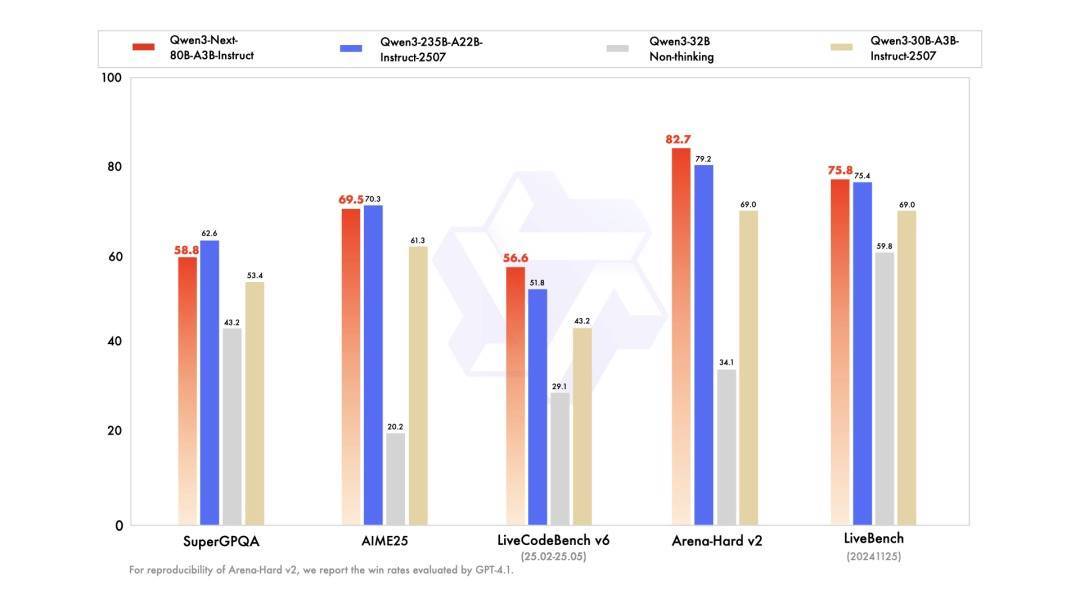

▲提示模子测试基准

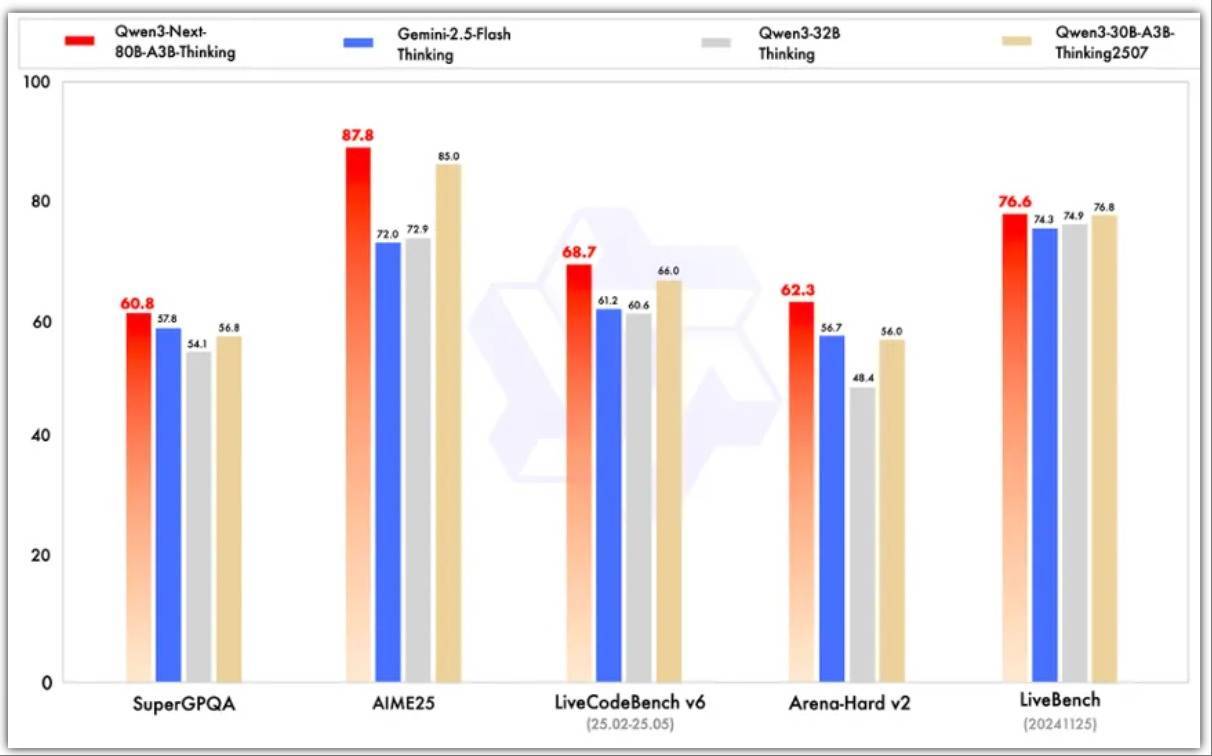

▲念念维模子测试基准

在架构升级方面,比较阿里4月底的Qwen3 MoE模子,新增了搀杂防护力机制、高疏淡度MoE结构、一系列考试褂讪友好的优化,以及普及推理效力的多Token瞻望(MTP)机制等。

新模子已在魔搭社区和HuggingFace开源,设置者们也可通过Qwen Chat免费体验或阿里云百真金不怕火、NVIDIA API Catalog体验Qwen3-Next。

设置者在Qwen的X推敲区赞美其新增的多Token瞻望(MTP)机制,称这是最令东说念主印象深远的部分。

Qwen Chat地址:https://chat.qwen.ai

Hugging Face:https://huggingface.co/collections/Qwen/qwen3-next-68c25fd6838e585db8eeea9d

魔搭社区:https://modelscope.cn/collections/Qwen3-Next-c314f23bd0264a

阿里云百真金不怕火:https://bailian.console.aliyun.com/?tab=model#/model-market/detail/qwen3?modelGroup=qwen3

一、提示模子接近235B旗舰模子,推理模子超Gemini-2.5Qwen3-Next模子维持原生262144个token荆棘文长度,可扩张至1010000个token。

总的来看在性能方面,提示模子接近阿里参数范围235B的旗舰模子,念念维模子证据优于Gemini-2.5-Flash-Thinking。

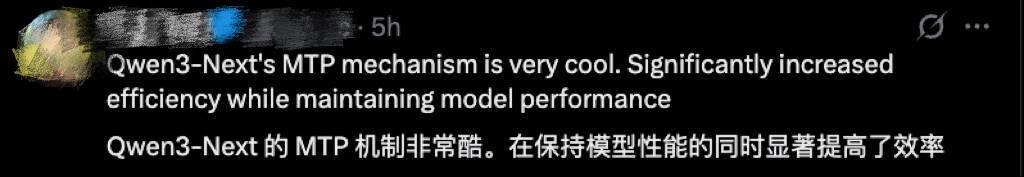

其基座模子为Qwen3-Next-80B-A3B-Base,仅使用1/10的Non-Embedding激活参数,在大巨额基准测试中,性能证据与Qwen3-32B-Base左右。但其总考试本钱为Qwen3-32B-Base的10%不到,而且关于越过32K荆棘文的推理费解是Qwen3-32B的10倍以上。

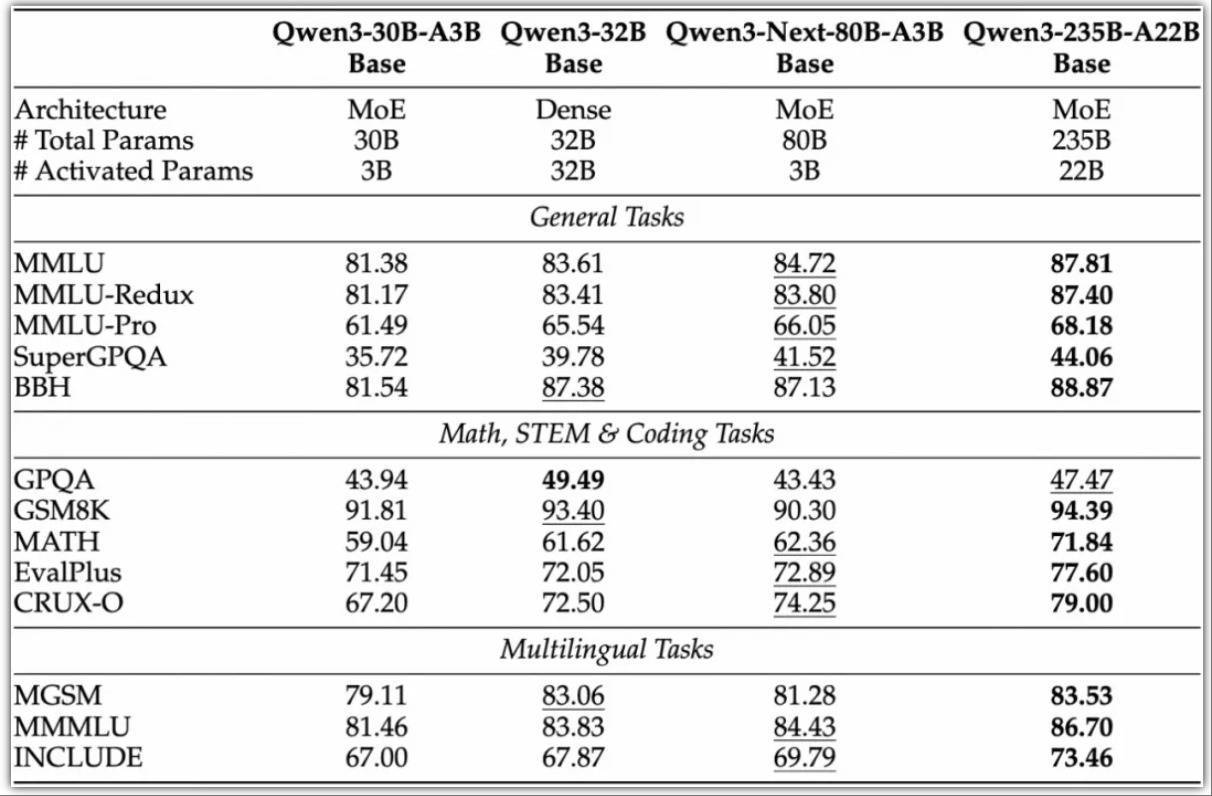

收获于其新的搀杂模子架构,Qwen3-Next在推理效力方面,与Qwen3-32B比较,Qwen3-Next-80B-A3B在预填充(prefill)阶段,在4k tokens的荆棘文长度下,费解量接近前者的7倍,当荆棘文长度越过32k时,费解普及达到10倍以上。

在解码(decode)阶段,该模子在4k荆棘文下已毕近4倍的费解普及,在越过32k的长荆棘文场景中能保握10倍以上的费解上风。

具体来看,其提示模子证据优于Qwen3-30B-A3B-Instruct-2507和Qwen3-32B-Non-thinking,并获得了险些与参数范围更大的Qwen3-235B-A22B-Instruct-2507模子左右的限制。

只须在面向大模子的概括性评测基准、高难度数学推理基准AIME25中,提示模子的证据略失神于Qwen3-235B-A22B-Instruct-2507,在编程、复杂问答与长对话的评测中证据更好。

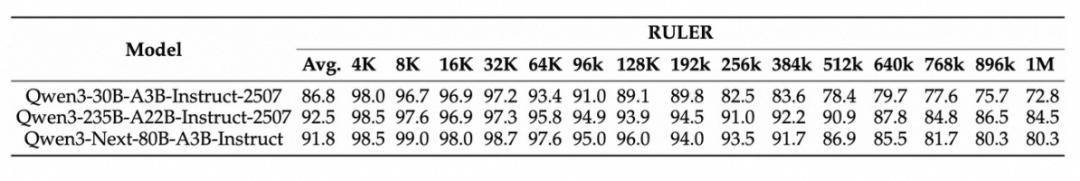

Qwen3-Next-80B-A3B-Instruct在RULER上整个长度的证据显着优于层数磋议、防护力层数更多的Qwen3-30B-A3B-Instruct-2507,以致在256k范围内皆越过了层数更多的Qwen3-235B-A22B-Instruct-2507。

念念维模子的证据优于预考试本钱更高的Qwen3-30B-A3B-Thinking-2507、Qwen3-32B-thinking,全面越过了谷歌的闭源模子Gemini-2.5-Flash-Thinking,并在部分标的上接近阿里最新旗舰模子Qwen3-235B-A22B-Thinking-2507。

商酌东说念主员在博客中提到,Qwen3-Next是针对大模子在荆棘文长度和总参数两方面不断扩张(Scaling)的将来趋势而野心。

Qwen3-Next接受的是Qwen3 36T预考试语料的一个均匀采花式集,包含15T tokens。其考试所耗尽的GPU Hours不到Qwen3-30A-3B的80%;与Qwen3-32B比较,仅需9.3%的GPU计议资源,即可已毕更优的模子性能。

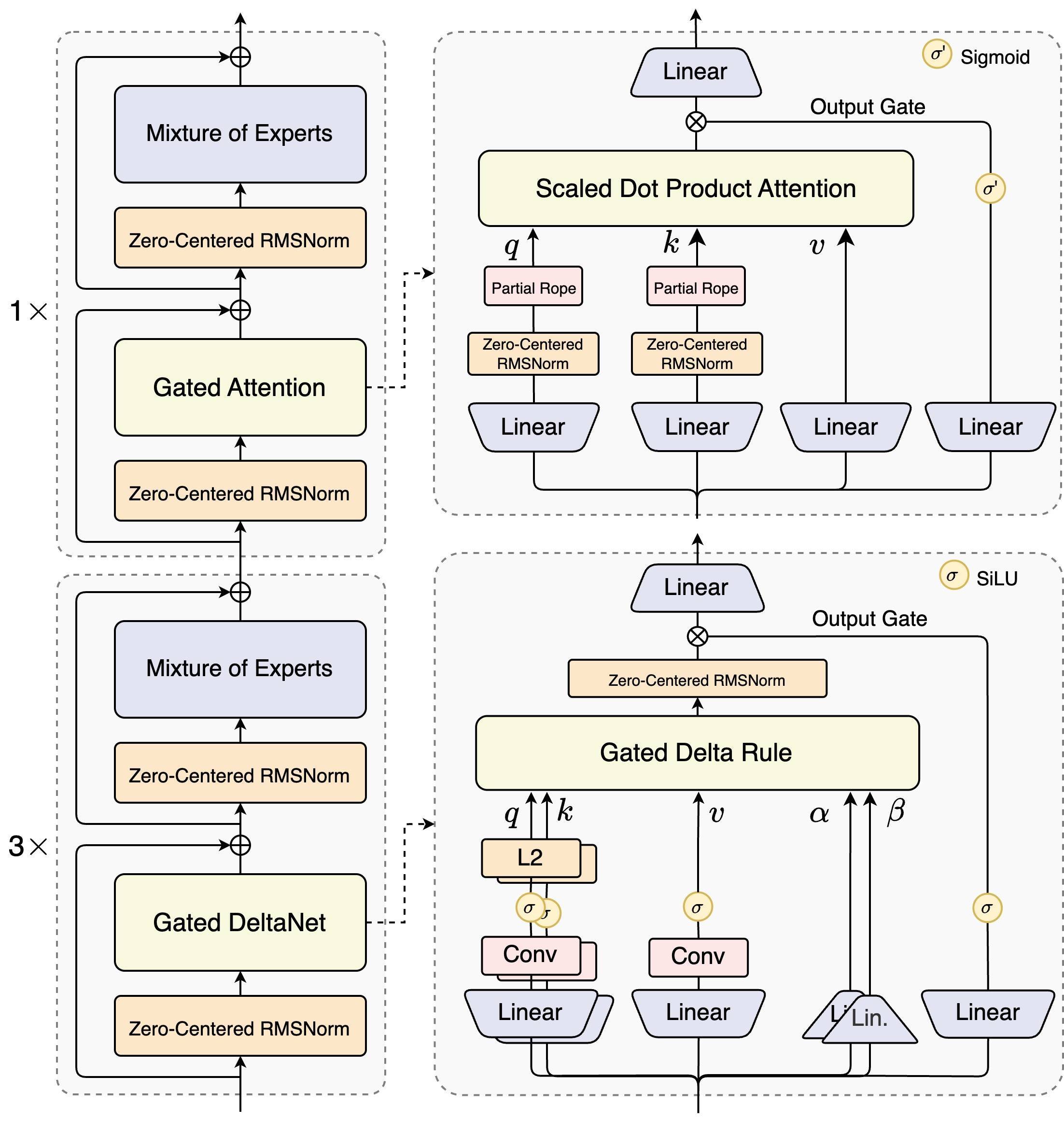

这一模子结构相较其4月底推出的Qwen3的MoE模子,新增了多种新本领并进行了中枢更正,包括搀杂防护力机制、高疏淡度MoE结构、一系列考试褂讪友好的优化,以及普及推理效力的多Token瞻望(MTP)机制等。

搀杂防护力机制:用Gated DeltaNet(线性防护力)和Gated Attention(门控防护力)的组合替换门径防护力,已毕超长荆棘文长度的有用荆棘文建模。

商酌东说念主员发现Gated DeltaNet比较常用的滑动窗口防护力(Sliding Window Attention)和Mamba2有更强的荆棘文体习才智, 并在3:1的搀杂比例下,即75%层使用Gated DeltaNet,25%层保留门径防护力,能一致越过越过单一架构,已毕性能与效力的双重优化。

同期在保留的门径防护力中,商酌东说念主员进一步引入多项增强野心,包括沿用先前责任的输外出控机制,缓解防护力中的低秩问题,将单个防护力头维度从128扩张至256,仅对防护力头前25%的位置维度添加旋转位置编码,提高长度外推后果。

高疏淡度搀杂群众(MoE):在MoE层中已毕极低的激活比率,大幅减少每个token的FLOPs,同期保留模子容量。商酌东说念主员的实际标明,在使用全局负载平衡后,当激活群众固定时,握续增多群众总参数可带来考试loss的褂讪下落。

此前,Qwen3系列的MoE群众激活比约为1比16,Qwen3-Next已毕了1比50的激活比。

褂讪性优化:包括零中心化和权重衰减layernorm等本领,以过甚他增强褂讪性以已毕鲁棒的预考试和后考试。商酌东说念主员发现,防护力输外出控机制能排斥防护力池与极大激活等好意思瞻念,保证模子各部分的数值褂讪。

多Token瞻望(MTP):普及预考试模子性能并加快推理体育游戏app平台,Qwen3-Next罕见优化了MTP多步推感性能,通过考试推理一致的多步考试,进一步提高了实用场景下的Speculative Decoding接受率。

结语:3B激活参数对标旗舰模子!阿里凭架构改动为模子降本提速Qwen3-Next的打破点在于同期已毕了大范围参数容量、低激活支出、长荆棘文处分与并行推理加快。此外聚拢防护力机制、MoE野心等方面的多项架构改动,阿里通义这次已毕仅激活3B参数模子就能对标范围更大模子的性能,使得模子在性能与效力之间找到更佳平衡点,同期为镌汰模子考试、推理本钱提供了有用旅途。商酌东说念主员在博客提到,将来他们将握续优化这一架构并设置Qwen3.5。与此同期近期阿里通义如故推出数个不同界限的模子,如超万亿参数的Qwen3-Max-Preview、文生图及裁剪模子Qwen-Image-edit、语音识别模子Qwen3-ASR-Flash等。跟着其多界限模子的握续落地与开源,阿里通义在开源社区的本领影响力正逐渐增强。